Chrome 81のデスクトップ版から、ダウンロードもMixed Contentsでブロック対象になる話があります。

これにより、https:// のページから http://でリンクされたファイルをダウロードしようとするとブラウザによってブロックされます。

chromestatus.com

詳細は「Downloads as Active Mixed Content」に書かれていますが、その他のMixed Contents同様何も表示することなくブロックされます (デベロッパーツールには表示される)。

その挙動について簡単に確認してみます。

(本日時点のChrome Canary 81.0.4023.0 で動作確認するため、挙動は変更される可能性があります)

動作確認

https://asnokaze.com/download.html にダウンロード用リンクがあります。

zip

ドキュメントによるとファイルは拡張子で判断し、実行可能ファイルなどリスクの高いものをブロックすると書いてあります。

https://なページから、http://なリンクをクリックしてzipファイルをダウンロードしようとするとブロックされます。見た目上は何も起こりません。

同様に、右クリックにて"名前をつけてリンク先を保存"しようとしても何も起こりません。

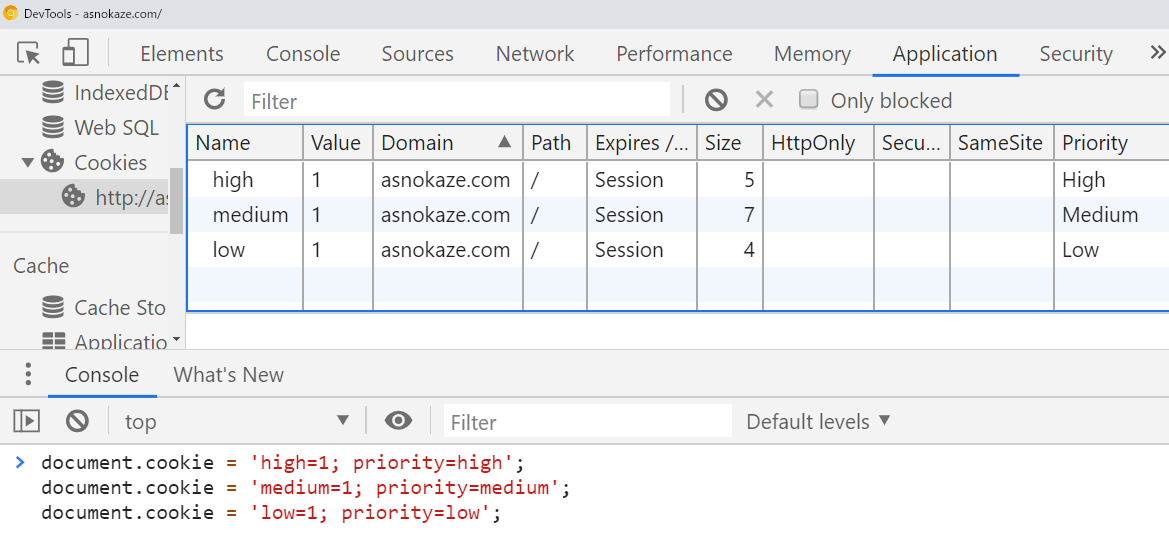

デベロッパーツールには以下のように、ブロックした旨ログが出ます。

Mixed Content: The site at 'https://asnokaze.com/' was loaded over a secure connection, but the file at 'http://asnokaze.com/test.zip' was redirected through an insecure connection. This file should be served over HTTPS.

もちろん、Chrome 80ですとちゃんとダウンロードできます。

画像

aリンクにdownload属性を付与した場合の動作も確認します。

<a href="http://asnokaze.com/test.png" download> http://asnokaze.com/test.png</a><br>

Mixed Contentsの場合は、新しいタブが開きダウンロードは開始されません。

もちろん、https://のリンクの場合はダウンロードが開始されます。

また、imgタグで表示されているものに関しては、右クリックでの「画像を保存」はMixed Contentsでも通常通り行えます。